1. Introdução

No campo da Contabilidade, principalmente na área de Auditoria Contábil, tem-se buscado cada vez mais estabelecer critérios para a obtenção de indícios de fraude em lançamentos contábeis. Para Attie (2010) existem várias definições para auditoria. Estas definições podem ser em relação aos ativos contábeis ou em relação aos ativos não contábeis. Motta Junior (2010) comenta que, como consequência dos diversos avanços tecnológicos, as técnicas de auditoria vêm sofrendo mudanças no sentido de adequar-se às necessidades deste novo cenário. Uma dela é o surgimento da auditoria contínua como reflexo direto destas mudanças. Assim, com os avanços tecnológicos, a auditoria contínua pode utilizar métodos de coleta de dados, estabelecendo resultados parciais sobre suspeitas de atividades fraudulentas em amostras ou subgrupos do conjunto total de dados.

Desde a metade dos anos 80, a lavagem de dinheiro tornou-se um significante problema global (Gao e Xu, 2009). Em escala global, a lavagem de dinheiro é a chave fundamental para o financiamento de grupos religiosos extremistas e para o tráfico de drogas. No Brasil, além destes, acredita-se que este tipo de crime seja utilizado para legalizar recursos advindos de atividades de corrupção. Em 2003, os principais órgãos brasileiros (Governos, Judiciário e Ministério Púbico) se uniram para desenvolver estratégias conjuntas contra a lavagem de dinheiro. As primeiras medidas nessa direção foram a criação do COAF e do Departamento de Combate a Ilícitos Cambiais e Financeiros no Banco Central. A estes seguiram-se diversos outros passos, estando entre eles a inauguração tribunais especializados em matéria de lavagem de dinheiro e a criação do Departamento de Recuperação de Ativos Ilícitos e Cooperação Jurídica Internacional no Ministério da Justiça (BRASIL, 2004).

He (2010) apresenta várias técnicas de lavagem de dinheiro, descritas a partir de 20 casos de estudo. Entre as mais comuns, o uso das instituições financeiras destaca-se como uma das técnicas mais usuais para este fim. De acordo com Schneider (2010) estima-se que em 2006 tenham sido lavados mais de 2.0-2.5 trilhões de dólares americanos, isto é, cerca de 5-6% do produto bruto global. O autor ainda destaca que no setor financeiro (bancos e fundos de investimento) devem ter sido lavados de 500 bilhões a um trilhão de dólares americanos em 2004 (Agarwal e Agarwal apud Schenider, 2010).

Na tentativa de coibir este crime, cada vez mais sistemas anti-lavagem de dinheiro têm sido implantados (Gao e Xu, 2009). Segundo os autores, alguns destes sistemas simplesmente transformam vastas quantidades de dados em grandes quantidades de relatórios que acabam por não facilitar a detecção on-line da lavagem de dinheiro. Gao e Xu (2009) também destacam que algumas das tradicionais soluções baseadas em normas sofrem com uma série de desvantagens, tais como ineficientes thresholds, elevado número de falsos positivos, insuficientes funções de reconhecimento de padrões e capacidades de processamento.

No Barsil o Banco Central é o órgão regulador do assunto e uma das autoridades administrativas encarregadas de promover a aplicação da Lei 9.613/1998 sobre Prevenção de Lavagem de Dinheiro. O Banco Central editou normas que estabelecem que as instituições financeiras devem manter atualizados os cadastros dos clientes além de controles internos para verificar a compatibilidade entre as correspondentes movimentações de recursos, atividade econômica e capacidade financeira dos usuários do sistema financeiro nacional (COAF, 2013). A facilidade de execução de operações financeiras no Brasil, através da internet, favorecem amplamente o processo de dissimulação da origem do dinheiro, ampliando as possibilidades de movimentação dos recursos das operações ilegais

Para Motta Junior (2010), uma vez que os avanços tecnológicos vêm provocando profundas mudanças nas organizações e na sociedade, eles devem impactar também nas técnicas de auditoria. Uma vez que os processos de auditoria demandam uma série de recursos para sua execução, sistemas de identificação de suspeitas de lavagem de dinheiro baseadas em análise estatística, segundo o autor, podem auxiliar na agilidade do processo de monitoramento. Gao e Xu (2009) propuseram um modelo conceitual de sistema de suporte à decisão assistido, onde agentes inteligentes objetivam auxiliar a expertise de especialistas. Entretanto, mesmo neste sistema, o agente de diagnóstico de comportamento implantado é baseado em regras arbitrárias e não no reconhecimento de padrões por meios estatísticos. Apesar da literatura internacional apresentar proposições de sistemas de controle contra a lavagem de dinheiro, estudos sobre o tamanho e desenvolvimento do crime de lavagem de dinheiro é ainda efetuado por poucos pesquisadores (Schneider, 2010) e o monitoramento on-line dos padrões de variação em lançamentos contábeis ainda é uma lacuna a ser preenchida. Deste modo, ao menos desde o conhecimento dos autores, um problema de pesquisa ainda descoberto é: "Como identificar padrões estatisticamente assinaláveis de suspeitas de fraude por lavagem de dinheiro?"

Este artigo contribui para o estado da arte ao propor três procedimentos estatísticos para o auxílio na ação de identificação de suspeitas de lavagem de dinheiro em instituições financeiras. Para tanto, a hipótese levantada é a de que lançamentos financeiros em contas de pagamentos seguem a Lei de Newcomb-Benford, que versa sobre a frequência de ocorrência do primeiro dígito significativo do lançamento contábil, tal qual descrito por Santos, Tenório e Silva (2003).

Os resultados obtidos por bootstrapp em oito séries reais classificadas como suspeitas e não suspeitas de lavagem de dinheiro de acordo com os critérios do banco Central mostraram que os procedimentos propostos apresentam diferentes sensibilidades quanto a sua capacidade de identificação dos indícios de lavagem de dinheiro. O tamanho da amostra também foi fator importante na variação dos resultados. Em função disso, tamanhos de amostra de referência são indicados para a utilização dos procedimentos.

2. Referêncial Teórico

2.1. Crime de Lavagem de Dinheiro

Lavagem de dinheiro é um termo utilizado para descrever o caminho pelo qual criminosos processam o dinheiro "sujo", fruto de atividades ilegais, através de sucessivas transações financeiras até que a fonte de aquisição ilegal dos fundos estejam obscuras e os recursos aparentem legitimidade (COAF, 2013?). Em resumo, lavagem de dinheiro é um processo diverso e frequentemente complexo que envolve transações em dinheiro.

O processo de lavagem de dinheiro envolve basicamente três passos independentes: inserção, estratificação e integração. Por inserção entende-se o processo de transferência dos recursos ilegais para o sistema financeiro de modo a evitar a detecção pelas instituições financeiras e autoridades governamentais. A estratificação é o processo da geração de uma série de transações que distanciem os recursos de sua fonte ilegal objetivando obscurecer o caminho da auditoria. Por fim, a integração é a inserção oculta dos recursos "limpos" na economia (Gao e Xu, 2009).

No esforço para detectar potenciais esquemas de lavagem de dinheiro foram determinados pelos gestores governamentais esquemas de avaliação (Ardizzi et al., 2012). Estes esquemas funcionam baseados em regras fixas baseadas em thresholds e na análise qualitativa dos cenários que levam ao rompimento destas barreiras. Uma vez que a maior parte das instituições financeiras estabelece um alvo baseado em um valor monetário, apenas alguns específicos casos de lavagem serão detectados. É o caso dos ataques de 11 de setembro ao World Trade Center. A investigação após os ataques apontou que os terroristas efetuaram frequentemente transações envolvendo quantias abaixo do limite estabelecido e, portanto, não detectáveis pelos thresholds estabelecidos (Ardizzi et al., 2012).

O tipo de análise efetuado normalmente para a detecção de suspeitas de lavagem de dinheiro é frequentemente relatada pelo elevado número de falsos positivos (Gao e Xu, 2009; ), isto é, transações que estão acima dos limites e, portanto, são marcadas como suspeitas mas não representam nenhum indício de lavagem de dinheiro. Em estatística afirma-se que este tipo de procedimento é sensível porém pouco específico. De fato esta análise está associada aos erros de decisão do tipo I e II dos procedimentos adotados. De acordo com Standing e van Vuuren (2003), em países onde os auditores são requisitados a reportar lavagem de dinheiro às autoridades muitos relutam em fazê-lo devido ao risco de serem processados no advento de não condenação ou falsa acusação. Isto é de sobremaneira potencializado pelos esquemas de identificação de suspeitas que, como relatado, apresentam frequentemente a ocorrência de alarmes falsos.

Detecção e prevenção à lavagem de dinheiro são atividades de difícil execução. Lavagem de dinheiro é um processo dinâmico que adapta-se rapidamente as mudanças das condições de operação da fiscalização. Os padrões de comportamento alteram-se de acordo com as técnicas adotadas para combatê-las, ou seja, sistemas fixos, baseados em normas em ambientes de transações eletrônicas não provêm adequada proteção ao sistema financeiro (Gao e Xu, 2009).

2.2. Processo de Auditorias

De acordo com O'Hanlon (2006), auditoria é um exame formal de contas por meio de referências as testemunhas e aos comprovantes. Para Attie (2010), a auditoria consiste na realização de uma avaliação reconhecida oficialmente e sistematizada pelos interessados, com a finalidade de assegurar que o sistema, programa, produto, serviço e processo aplicáveis perfaçam todas as características, critérios e parâmetros exigidos. Deste modo, pode-se afirmar que a auditoria é um mecanismo que visa ao controle e à fiscalização dos processos e normas, seja de uma empresa, de um setor público ou privado.

Note que a sistematização citada refere-se à necessidade do processo de auditoria ser estruturado e direcionado. Além disso, o processo precisa ser independente, no sentido de não viesado ou isento de preconceitos. Por fim, a avaliação das observações necessita ser objetiva, isto é, baseada em evidências objetivas.

O'Hanlon (2006) afirma o quanto é comum auditores usar critérios e requisitos como lista de verificação na condução de auditorias baseadas em critérios. É o que ocorre, por exemplo, nas avaliações quanto as suspeitas de lavagem de dinheiro onde auditores baseiam-se no conjunto de normas estabelecidas pelo Banco Central do Brasil e demais organismos de prevenção e combate a lavagem de dinheiro. Segundo o autor, este tipo de auditoria, embora abrangente, frequentemente fracassa, principalmente no que tange a eficácia. Este ponto é também destacado por Gao e Xu (2009) que destacam a quantidade de erros associados as decisões de investigar ou não contas em função do levantamento de suspeitas infundadas pelos critérios normativos estabelecidos arbitrariamente.

Assim como O'Hanlon (2006), Motta Junior (2010) expressa que um sistema de auditoria eficiente será aquele que se afasta da auditoria baseada em critérios e passa a mover-se em direção de uma auditoria baseada em processo, com uma visão mais sistêmica do problema. Em relação a uma visão sistêmica do problema, Ardizzi et al. (2012) definiram um modelo de demanda por depósitos em dinheiro utilizando como variável dependente os valores de lançamentos em dinheiro em contas correntes e como fatores explicativos uma componente estrutural onde espera-se sejam capturadas as movimentações legais, uma componente econômica a capturar demandas de depósitos relacionadas ao trabalho irregular e fraudes em impostos e uma componente de lavagem de dinheiro. Esta última inclui dois indicadores de difusão de atividades criminosas relacionadas ao tráfico (venda de drogas, prostituição e receptação) e exercício do poder para o controle do território (extorsões pelo crime organizado).

Apesar deste modelo avaliar o processo de lavagem de dinheiro como uma componente das movimentações financeiras, isto se dá em escala macro e serve para estimativas de volume de recursos em cada componente. Em escala micro, modelos baseados na clusterização de clientes buscando estabelecer comportamentos comuns e fontes de evidências assinaláveis, definidas estatisticamente, não são do conhecimento do autor.

2.3. Lei de Benford

Benford (1938) apresentou uma Lei, baseado em estudos de tábuas de logaritmos, que aponta diferenças entre as frequências observadas entre os primeiros dígitos significativos. A Lei de Benford aponta que, no caso de tabelas de logaritmos, os dígitos menores eram muito mais utilizados quando observada a distribuição de frequências destes dígitos. O resultado destes estudos apontou as frequências relativas apresentadas na Tabela 1. Resultados similares aos apresentados na Lei de Benford, que corroboram para sua Lei, foram encontrados em diversas áreas do conhecimento, tais como apresentados por Nigrini (1995), Durtschi et al. (2004) e Roukema (2009)

Tabela 1. Frequências relativas dos primeiros dígitos significativos no

uso de Tabelas Logarítmicas

X |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

% |

30,10 |

17,61 |

12,49 |

9,69 |

7,92 |

6,69 |

5,80 |

5,12 |

4,58 |

Fonte: Adaptado de Benford (1938)

Assim, a função distribuição da Lei de Benford pode ser expressa por:

![]()

A frequência dos primeiros dígitos significativos pode desviar da Lei de Benford por uma enorme gama de razões. Eles podem, por exemplo, ser fabricados ou alterados pela ação humana. Nestes casos, a aplicação da Lei é extremamente útil na detecção de fraudes em dados financeiros (NIGRINI, 2000). Esta detecção é feita a partir da comparação entre a distribuição empírica e a distribuição teórica, expressa pela Lei. Porém, apontar corretamente se estas distribuições são similares ou diversas (evidência de fraude) pode não ser uma tarefa simples, principalmente quando se tratarem de amostras de um universo de possíveis valores observados. Isto porque é necessário inferir sobre a possibilidade de fraude, considerando os possíveis erros inerentes ao processo de amostragem e de decisão. Uma estratégia para a tomada de decisão sobre a existência de indícios de fraude pode ser a utilização de testes de hipóteses estatísticas.

2.4 Testes de hipóteses

Em teoria da amostragem, procura-se definir os erros em termos de erros sistemáticos e erros de aleatoriedade. Os erros sistemáticos podem ser verificados e muitas vezes corrigidos, pois representam erros de digitação, coleta ou leitura dos instrumentos de medição. Já os erros derivados da aleatoriedade, inerentes a todo e qualquer processo de seleção amostral probabilístico, não podem ser evitados. Estes erros podem levar a decisões errôneas e em inferência estatística são conhecidos como erro do tipo I (ou a) e erro do tipo II (ou b) (MOOD et al, 1974). O Quadro 1 apresenta esses erros e sua relação com as hipóteses testadas. Em linhas gerais, o erro do tipo I (a) é a probabilidade de rejeição da hipótese nula (H0) quando esta é verdadeira. Este erro também é conhecido como nível de significância do teste de hipóteses. O erro do tipo II (b), por sua vez, é a probabilidade de aceitação de H0 quando esta é verdadeira. O poder de um teste é a capacidade desse teste em rejeitar H0 quando H0 é falso e esse poder é medido através da probabilidade complementar ao erro do tipo II (1-b).

Quadro 1. Erros dos tipos I e II em Testes de Hipóteses

Decisão Estatística |

H0 Verdadeiro |

H0 Falso |

Aceita H0 |

Decisão Correta |

Erro do tipo II (b) |

Rejeita H0 |

Erro do tipo I (a) |

Decisão Correta Poder do Teste (1-b) |

Fonte: Adaptado de McClave et al, 2009, p.322.

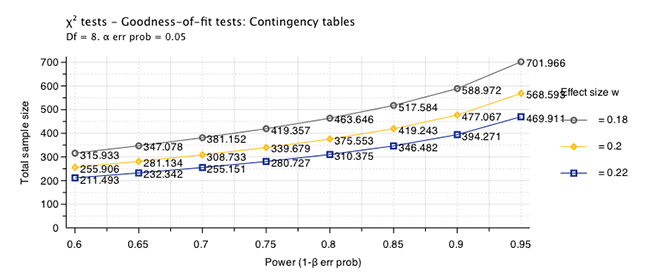

A confiança e poder de um teste de hipóteses estão também associados ao tamanho da amostra. A relação entre tamanho da amostra, poder e nível de significância podem ser observados na Figura 1. Para um tamanho de efeito fixo, com nível de significância fixo em 5%, percebe-se que somente é possível aumentar o poder de um teste se aumentarmos a amostra. Do mesmo modo, se é desejado identificar diferenças menores, isto é, deseja-se identificar tamanhos de efeito menores como significativos, amostras maiores são necessárias.

Figura 1. Tamanhos de Amostra para teste qui-quadrado

Para determinar o tamanho da amostra para a execução de um teste qui-quadrado sobre uma tabela de contingência com 8 graus de liberdade (a lei de Benford refere-se a 9 digitos significativos) deve-se definir o tamanho do efeito que deseja-se identificar. Softwares podem ajudar na tarefa de determinar o tamanho do efeito, mas cabe aos especialistas na área definir o threshold a ser detectado.

2.5. Monitoramento on-line

De acordo com Contreras (1989), o sucesso na implantação de sistemas de controle estatístico do processo on-line requer uma estratégia cuidadosa para combinar os procedimentos de hardware e software para a coleta dos dados, análise e apresentação dos resultados. Geralmente em indústrias com ambientes automatizados, um volume muito grande de dados é observado para efetuar o monitoramento das características de qualidade do que está sendo produzido. Do mesmo modo, lançamentos contábeis podem representar um grande volume de informações que necessitam ser armazenados, manejados, analisados e resultados necessitam ser apresentados com indicativos de conclusões sobre os fatos ali apresentados. Na indústria, sistemas de controle estatístico do processo são utilizados para este fim. Estes sistemas objetivam estabelecer padrões de comportamento das variáveis analisadas para monitorar as respostas observáveis tomando em consideração uma variabilidade comum ao processo. Uma vez que causas especiais de variação (não comuns) sejam introduzidas no processo, estes sistemas são capazes de identificar estas alterações como variações assinaláveis, sendo o sistema então responsável por emitir um alerta de que o processo passou a operar em um estado fora de controle estatístico.

Estes procedimentos não são exclusivamente utilizados no monitoramento de padrões de qualidade na indústria. Woodall et al. (2008) afirma que a detecção de aumento na taxa de eventos não usuais em relação a aspectos críticos na área da saúde são fundamentais. O objetivo da vigilância sobre estas alterações é detectar alterações na incidência de certos tipos de doenças. Note que, neste caso, as observações são discretas e, segundo o autor, comportam-se de acordo com um modelo de distribuição de Poisson (contagem de casos em um dado período). Métodos estatísticos tem sido frequentemente utilizados na detecção de mudanças em domínio do tempo finito (Biau et al., 2013; Park et al., 2013, Duclos e Voirin, 2010)

O objetivo de um sistema de monitoramento é detectar condições que desviem-se do padrão estatístico o mais rápido possível. Para tanto, diversos esquemas de análises podem ser utilizados de acordo com Contreras (1989):

- Detecção automática de condições especiais: utiliza reconhecimento de padrões em associação com um conjunto de regras estabelecidas. O sistema pode detectar quando o processo está afastando-se do padrão estabelecido.

- Análise multidimensional: utiliza cartas de controle para avaliar um simples aspecto do comportamento da característica da qualidade, por exemplo, alguma tendência. Frequentemente múltiplas cartas de controle são necessárias.

- Análise com múltiplos sinais: dados de controle do processo são coletados para muitas características. Os sinais podem ser independentes, porém são relacionados em função do tempo. Em função disto, é conveniente trabalhar com múltiplos sinais ao mesmo tempo.

- Análise multivariada: se as características que descrevem o processo são estatisticamente dependentes, o controle multivariado do processo é a técnica que deve ser utilizada. Neste caso, pode-se estudar um comportamento univariado como uma componente do sinal.

- Análise de dados autocorrelacionados: A suposição usual de que as observações são independentes estatisticamente entre e dentro das amostras de controle é violada no caso onde toda a coleção de dados é mensurada. Uma série de técnicas baseadas em séries temporais podem ser utilizadas para analisar os dados on-line.

Uma vez que aplicações deste nível em lançamentos contábeis para avaliação de fraudes apresenta-se como uma abordagem original, um plano de implantação e integração com outros sistemas deve ser cuidadosamente elaborado. Este processo deve ter ênfase no aprendizado do processo e na adaptação, inclusive pelo fato de as estratégias de fraudar o sistema financeiro serem dinâmicas e variadas. Neste caso, técnicas robustas e adaptativas de modelagem, como o filtro de Kalman, e sistemas de monitoramento do tipo CuSum, EWMA ou recursos de estatística de varredura podem ser úteis na concepção de um sistema de aprendizagem dinâmica para prevenção e detecção de indícios de fraudes em lançamentos contábeis.

3. Procedimentos propostos para avaliação de fraudes

3.1. Gráfico de Probabilidade de Benford

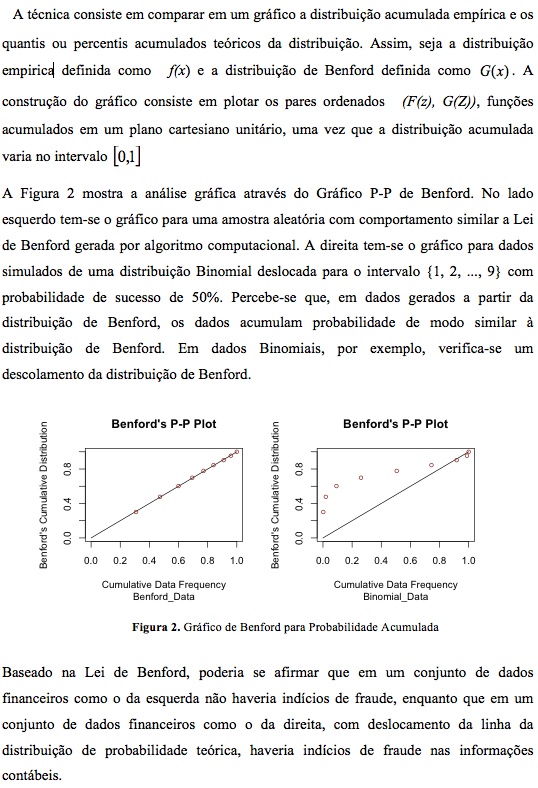

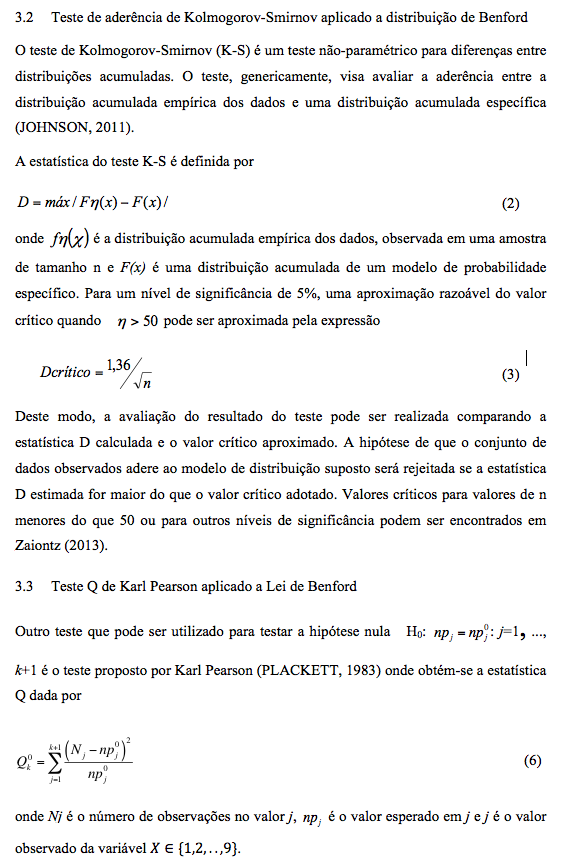

Uma estratégia simples para verificar aderência a um modelo probabilístico é a análise gráfica. Gráficos do tipo Q-Q (quantis) e P-P (percentis) foram apresentados originariamente por Wilk & Gnanadesikan (1968) e sua avaliação, além de simples, é eficiente na identificação de grandes desvios de uma determinada curva de distribuição.

4. Resultados

Foram obtidas 8 séries de lançamentos em conta corrente de clientes corporativos de instituições financeiras onde três séries representam casos com suspeita de lavagem de dinheiro de acordo com os critérios adotados pelo do Banco Central do Brasil e cinco séries representam casos onde não há suspeita de lavagem de dinheiro de acordo com os mesmos critérios. Cada série possui a sequência de lançamentos durante um período de um mês. A partir de cada série coletada, 5.000 amostras aleatórias sem reposição, com tamanho variando de 350 a 600, foram sorteadas.. A descritiva quanto ao tamanho da série e suspeita de lavagem de dinheiro pelos critérios do Banco Central do Brasil são apresentados na Tabela 3. A Figura 3 apresenta os resultados do gráfico de probabilidade de Benford para as oito séries originais.

Tabela 3. Tamanho das séries e indicativo de suspeita de lavagem

de dinheiro nos lançamentos baseado nas diretrizes do Banco Central

Série |

Tamanho |

Suspeita de Lavagem |

|

1 |

2439 |

Não |

|

2 |

2010 |

Não |

|

3 |

2625 |

Não |

|

4 |

2397 |

Não |

|

5 |

2763 |

Não |

|

6 |

2626 |

Sim |

|

7 |

3482 |

Sim |

|

8 |

670 |

Sim |

|

Observa-se que, considerando o volume total de dados, as distribuições não aparentam grandes desvios da distribuição de Benford, com exceção da série 2, cujo gráfico é exibido na primeira linha, coluna dois. Assim, em uma primeira análise, os dados provenientes das oito séries aderem ao modelo de distribuição de Benford, em desacordo com a classificação apresentada na Tabela 3, efetuada de acordo com as diretrizes do Banco Central do Brasil.

As Tabelas 4 e 5 apresentam a probabilidade de rejeição da hipótese nula de aderência ao modelo de Benford em relação aos testes de K-S e Qui-Quadrado de Pearson. Estes resultados foram computados para diversos tamanhos de amostra, variando de 300 a 600 sendo obtidos via o procedimento de bootstrapp. Foram selecionadas mil amostras de cada tamanho com reposição e obteve-se a proporção de vezes em que o teste não rejeitava a hipótese nula.

Figura 3. Benford P-P Plot das oito séries coletadas

Tabela 4. Probabilidade de rejeição da hipótese de aderência à distribuição de Benford frente ao teste KS

n |

Serie 1 |

Serie 2 |

Serie 3 |

Serie 4 |

Serie 5 |

Serie 6 |

Serie 7 |

Serie 8 |

300 |

0.9486 |

0.9806 |

0.9404 |

0.8936 |

0.8174 |

0.5428 |

0.7796 |

0.4782 |

350 |

0.9748 |

0.9952 |

0.9748 |

0.9350 |

0.8916 |

0.6422 |

0.8482 |

0.6054 |

400 |

0.9888 |

0.9980 |

0.9870 |

0.9708 |

0.9264 |

0.7104 |

0.8964 |

0.7776 |

450 |

0.9968 |

0.9998 |

0.9946 |

0.9812 |

0.9520 |

0.7734 |

0.9426 |

0.8742 |

500 |

0.9984 |

1.0000 |

0.9986 |

0.9922 |

0.9758 |

0.8406 |

0.9648 |

0.9678 |

550 |

1.0000 |

1.0000 |

0.9996 |

0.9960 |

0.9860 |

0.8702 |

0.9774 |

0.9974 |

600 |

1.0000 |

1.0000 |

1.0000 |

0.9988 |

0.9962 |

0.9218 |

0.9898 |

1.0000 |

Para o tamanho de amostra sugerido na seção 4 (400 observações) observa-se que as primeiras 4 séries apresentam resultados de aderência ao modelo de Benford, de acordo com o teste K-S, em mais de 95% das amostras selecionadas por bootstrapp, isto é, o resultado nos apresenta a confiança do teste em afirmar que estas séries não apresentam indícios de lavagem de dinheiro. Por outro lado, as amostras obtidas por bootstrapp das séries 5 a 8 e avaliadas frente ao teste K-S aceitaram a hipótese de nulidade de que os dados seguem o modelo de distribuição de Benford em razão menor do que 95%. Uma vez adotado o nível de significância de 5%, estes resultados apontam que, segundo o teste K-S, há indicíos de lavagem de dinheiro nas séries 5 a 8 uma vez que a confiança dos resultados é menor do que 95% para a amostra de tamanho 400.

Tabela 5. Probabilidade de rejeição da hipótese de aderência à distribuição de Benford frente ao teste Qui-Quadrado

n |

Serie 1 |

Serie 2 |

Serie 3 |

Serie 4 |

Serie 5 |

Serie 6 |

Serie 7 |

Serie 8 |

300 |

0.9920 |

0.9982 |

0.9732 |

0.9428 |

0.9508 |

0.9044 |

0.8666 |

0.7064 |

350 |

0.9984 |

1.0000 |

0.9902 |

0.9760 |

0.9802 |

0.9584 |

0.9280 |

0.8350 |

400 |

0.9998 |

1.0000 |

0.9972 |

0.9928 |

0.9914 |

0.9808 |

0.9664 |

0.9228 |

450 |

1.0000 |

1.0000 |

0.9992 |

0.9970 |

0.9962 |

0.9934 |

0.9838 |

0.9756 |

500 |

1.0000 |

1.0000 |

0.9998 |

0.9982 |

0.9994 |

0.9952 |

0.9918 |

0.9964 |

550 |

1.0000 |

1.0000 |

1.0000 |

0.9998 |

0.9998 |

0.9994 |

0.9954 |

0.9998 |

600 |

1.0000 |

1.0000 |

1.0000 |

1.0000 |

1.0000 |

0.9996 |

0.9984 |

1.0000 |

Note que aumentando o tamanho da amostra para 450 os resultados passam a apresentar os mesmos resultados das supeitas apontadas na Tabela 3. Pressupondo que os critérios do Banco Central do Brasil para avaliação da suspeita quanto à lavagem de dinheiro são adequados, uma amostra maior do que o estabelecido aumenta a confiabilidade dos resultados. Entretanto, se o tamanho da amostra for igual ou maior do que 500, os resultados passam a indicar que as séries 7 e 8 passam a ser consideradas não suspeitas. Isto destaca dois fatores: a definição do tamanho da amostra é um passo importante para a observação dos resultados e a decisão quanto ao nível de significância adotado deve ser efetuada a priori do início das análises para evitar viéses de interpretação dos resultados.

Considerando o teste Qui-Quadrado de Pearson, observa-se que para amostras de tamanho 400, o procedimento é mais liberal do que o K-S, não rejeitando a hipótese de aderência ao modelo de Benford com maior frequência nas amostras selecionadas por bootstrapp. Neste caso verificou-se que o procedimento aceita desvios maiores da distribuição em relação aqueles observados pelo teste K-S. Neste tamanho de amostra, apenas a série 8 não apresentou indícios de aderência ao modelo proposto de acordo com os resultados da Tabela 4. Com o aumento do tamanho da amostra, o comportamento entre os testes K-S e Qui-Quadrado são similares. Note que para uma amostra menor (n=300) o teste concorda com os critérios adotados pelo Banco Central do Brasil para a classificação da suspeita quanto à lavagem de dinheiro. Neste aspecto, o teste mostrou-se mais econômico, uma vez que é necessário um número menor de observações para equipar-se os resultados. Uma vez que o tamanho da amostra foi determinado para este teste particular, os resultados apontam que, no tamanho adequado, os procedimentos adotados pelo Banco Central do Brasil para suspeita de lavagem de dinheiro são mais rigorosos do que o procedimento Qui-Quadrado.

5. Considerações finais

Crime de Lavagem de Dinheiro caracteriza-se por um conjunto de operações comerciais ou financeiras que buscam a incorporação de recursos, bens e valores de origem ilícita na economia de cada país, de modo transitório ou permanente, e que se desenvolvem por meio de um processo dinâmico.

Com base na respectiva Lei 9.613, que versa sobre a Lavagem de Dinheiro, atribui-se às pessoas físicas e jurídicas de diversos setores econômico-financeiros maior responsabilidade na identificação de clientes e manutenção de registros de todas as operações e na comunicação de operações suspeitas sujeitando-as ainda as penalidades administrativas pelo descumprimento das obrigações. Com isso, esse artigo visa à importância de identificação de suspeita de Lavagem de Dinheiro. A partir da hipótese de que os primeiros dígitos significativos de lançamentos financeiros distribuem-se conforme a Lei de Benford, procurou-se desenvolver procedimentos estatísticos, passíveis de implantação em sistemas de informação, para avaliar de forma automatizada a ocorrência de indícios de Lavagem de Dinheiro.

Os resultados analisados em oito séries obtidas de lançamentos de contas apresentaram concordância com os critérios estabelecidos pelo Banco Central do Brasil. O rigor da análise para a concordância esteve relacionada ao tamanho da amostra no caso dos testes de hipóteses propostos. Enquanto o teste K-S concordou com a classificação de suspeita de lavagem de dinheiro com as diretrizes do Banco Central em amostras de tamanho n=450, o teste Qui-Quadrado obteve esta concordância em amostras selecionadas de tamanho n=300. Para o tamanho da amostra determinado a priori (n=400), o procedimento K-S foi mais conservador, indicando suspeitas de Lavagem de Dinheiro em séries onde os critérios do Banco Central do Brasil não as apresentava. Por outro lado, o teste Qui-Quadrado apontou que séries cujas diretrizes do Banco Central apontavam suspeitas de Lavagem de Dinheiro, não distanciavam-se o suficiente da distribuição de Benford.

Os resultados observados podem ser considerados satisfatórios, entretanto não objetivou-se apresentar uma solução definitiva para o problema da identificação de suspeitas de Lavagem de Dinheiro. A principal contribuição deste trabalho é apresentar um método cientifico não arbitrário para avaliação de processos no intuito de aprimorar a identificação de Lavagem de Dinheiro. Os resultados apresentam um avanço significativo na área, abrindo espaço para avaliação de novos modelos que aprimorem os métodos existentes para controles de fraude em lavagem de dinheiro.

Referências

ARDIZZI, G.; PETRAGLIA, C.; PIACENZA, M.; SCHNEIDER, F.; TURATI, G. (2012) Estimating Money Laundering through a "Cash Deposit Demand" Approach. XXIV Conferenza Società italiana di economia pubblica: Economia informale, evasione fiscale e corruzzione. Pavia, IT.

ATTIE, W. (2010). Auditoria: conceitos e Aplicações. São Paulo: Ed. Atlas.

BACEN. (2013) Ação do Estado e papel do Banco Central. Disponível em: <http://www.bcb.gov.br/?ACAOESTADO>. Acesso em: 20/06/2013.

BENFORD, F. (1938) The law of anomalous numbers. Proceedings of the American Philosophical Society, Vol. 78, No. 4, p.551–572.

BIAU, D. J.; WEISS, K. R.; BHUMBRA, R. S.; DAVIDSON, D. B.; CHRIS, WUNDER, J. S.; FERGUSON, P. C. (2013) Using the CUSUM Test to Control the Proportion of Inadequate Open Biopsies of Musculoskeletal Tumors. Clinical Orthopaedics and Related Research, 471(3), 905–914.

BRASIL (2004) Ministério da Justiça. Lavagem de Dinheiro, Enccla, Ações/Metas. Consultado em 21 de outubro de 2013. Disponível em http://portal.mj.gov.br.

BRASIL. (2012) Lei nº 12.683, de 9 de julho de 2012. Altera a Lei no 9.613, de 3 de março de 1998, para tornar mais eficiente a persecução penal dos crimes de lavagem de dinheiro. Disponível em: <http://www.planalto.gov.br/ccivil_03/ato2011-2014/2012/Lei/L12613.htm>. Acesso em: 13/06/2013.

BRASIL. (1998) Lei nº 9.613. Dispõe sobre os crimes de "lavagem" ou ocultação de bens, direitos e valores; a prevenção da utilização do sistema financeiro para os ilícitos previstos nesta Lei; cria o Conselho de Controle de Atividades Financeiras - COAF, e dá outras providências. Disponível em: <http://www.planalto. gov.br/ccivil_03/Leis/l9613.htm>. Acesso em: 13/06/2013.

COAF. (2013) Sobre Lavagem de Dinheiro. Disponível em: <https://www.coaf.fazenda.gov.br/>. Acesso em: 18/10/2013.

CONTRERAS, L. E. (1989) Implementation Strategies for On-Line Statistical Process Control Systems. In: Statistical Process Control in Automated Manufacturing. Quality and Reliability v. 15. Ed. Marcel Dekker, Inc. Organizado por Keats, B. e Hubele, N. F.

DUCLOS, A.; VOIRIN, N. (2010) The p-control chart: a tool for care improvement. International Journal for Quality in Health Care, 22(5), 402–407.

DURTSCHI, C.; HILLISON, W.; PACINI, C. (2004) The Effective Use of Benford's Law to Assist in Detecting Fraud in Accounting Data. Journal of Forensic Accounting, V, p.17-34.

GAO, S.; XU, D. (2009) Conceptual modeling and development of an intelligent agent-assisted decision support system for anti-money laundering. Expert Systems with Applications, 36, p.1493-1504.

HE, P. (2010) A typological study on money laundering. Journal os Money Laundering Control, 13(1), p.15-32.

JOHNSON, R. A. Probability and Statistics for Engineers. (2011) Boston: Prentice Hall.

McCLAVE, J. T., BENSON, P. G., SINCICH, T. (2009) Estatística para Administração e Economia. São Paulo: Pearson Prentice Hall.

MOOD, A. M., GRAYBILL, F. A., BOES, D. C. (1974) Introduction to the Theory of Statistics. New York: McGraw-Hill.

MOTTA JÚNIOR, E. P. (2010) Investigação de modelo de auditoria contínua para tribunais de contas. Dissertação (Mestrado) - Universidade Federal de Pernambuco. Recife.

NIGRINI, M. (2000) Digital Analysis Using Benford's Law: Tests Statistics for Auditors. Vancouver: Global Audit Publications.

NIGRINI, M. Digital Analysis Using Benford's Law: Tests Statistics for Auditors. Vancouver: Global Audit Publications, 2000.

O'HANLON, T. (2006) Auditoria da Qualidade: com base na ISO9001:2000, conformidade agregando valor. São Paulo: Ed. Saraiva.

PARK, Y.; BAEK, S. H.; KIM, S.-H.; TSUI, K.-L. (2013) Statistical Process Control-Based Intrusion Detection and Monitoring. Quality and Reliability Engineering International, ahead to print.

PLACKETT, R. L. (1983) Karl Pearson and the Chi-Squared Test. International Statistical Review, Vol. 51, No. 1, p.59–72.

PLACKETT, R. L. (1983) Karl Pearson and the Chi-Squared Test. International Statistical Review. Vol. 51, No. 1, p.59–72.

ROUKEMA, B. (2009) Benford's Law Anomalies in the 2009 Iranian Presidential Election. Annals to Applied Statistics.

SCHENIDER, F. (2010) Turnover of organized crime and money laundering: some preliminary empirical findings. Public Choice, 144, p.473-486.

STANDING, A.; VAN VUUREN,H. (2003) The role of auditors: Research into organized crime and money laundery. Institute for Security Studies. Paper 73.

WILK, M. B.; GNANADESIKAN, R. (1968) Probability plotting methods for the analysis of data. Biometrika. Vol. 55, No. 1, p.1-17.

WOODALL, W. H.; MARSHALL, J. B.; JONER, M. D., JR; FRAKER, S, E,; ABDEL-SALAM, A-S. G. (2008) On the use and evaluation of prospective scan methods for health-related surveillance. Journal of the Royal Statistical Society A, 171, P.1, p.223-237.

WRIGHT, K. Benford's Law. Disponível em: <http://wiki.r-project.org/rwiki/doku.php?id=tips:stats-distri:benford>. Acesso em: 21/01/2010.

ZAIONTZ, C. Real Statistics Using Excel. Disponível em: <http://www.real-statistics.com/statistics-tables/kolmogorov-smirnov-table>. Acesso em: 04/07/2013